你看一下你这个包是不是坏掉了 /data/beh/core/spark/chdalib/protobuf-java-2.5.0.jar

- Spark 在 yarn 集群中提交任务失败

- 数据开发与 ETL 的区别

- 数据开发与 ETL 的区别

- oracle 空间配额问题。求大神指教。

- MapReduce 编程系列

- 后台关于异步处理

- 虚拟机安装总是出这个问题

- 后台关于异步处理

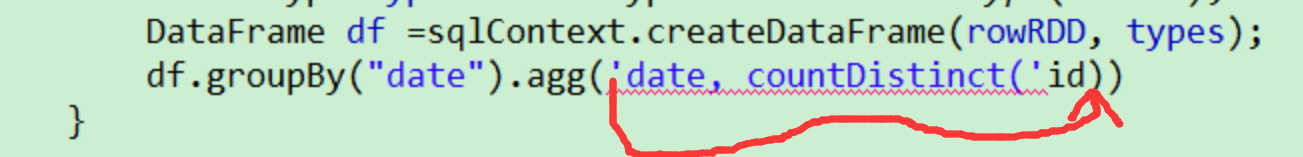

- 用 java 写 spark 的聚合函数格式是什么

- 用 java 写 spark 的聚合函数格式是什么

- 用 java 写 spark 的聚合函数格式是什么

- 用 java 写 spark 的聚合函数格式是什么

- 用 java 写 spark 的聚合函数格式是什么

- 字段变化的表在大数据中如何存储 ?

- > load data local inpath '/opt/hive/student.txt' into table db_hivetest.student; 报错是为什么?