1.spark 创建 hbase表报错,该怎么解决?

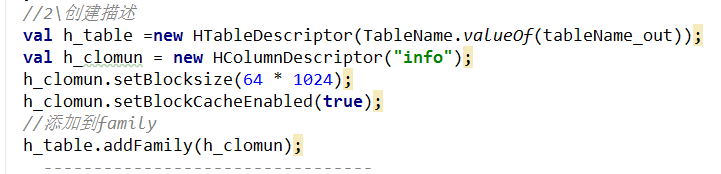

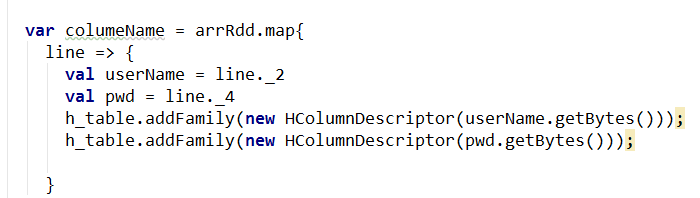

代码:

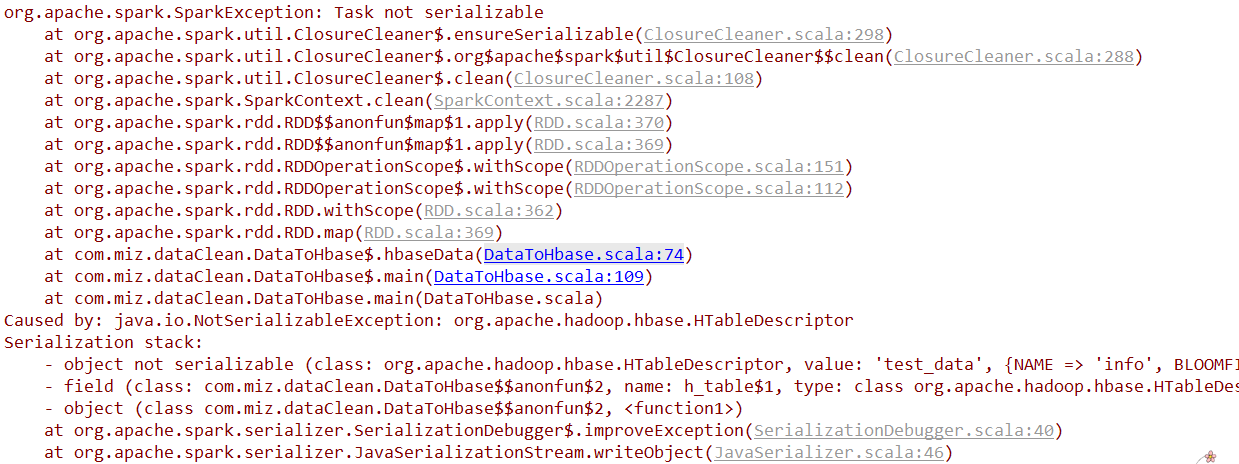

报错:

2.spark 连接mysql ,spark中能否直接建表?

关于 spark hbase MySQL 的几个问题?

成为第一个点赞的人吧

回复数量: 1

-

第一个问题:

你使用的hbase的类没有继承Serializable,spark要求在rdd的function中的类都要继承Serializable。

不过你现在使用的是hbase现有的类,所以没办法修改代码让其继承Serializable,那可以借助spark的KryoSerializer进行序列代,比如conf.set("spark.serialize",classOf[KryoSerializer].getName()) conf.registerKryoClasses(Array[Class[_]](classOf[ImmutableBytesWritable]))或者把hbase的类放在rdd的function里面

第二个问题:

可以,使用SparkSession或者SQLContext都可以