是不是权限问题

.ssh目录的权限为700

authorized_keys的权限为600

- 设置 SSH 免密登录仍需密码?

- 进入 hbase shell 报错?

- Docker 容器上部署 Hadoop?

- Hadoop 50070 端口没有监听?

- CDH 安装 MySQL 在那台机子上?

- Hadoop 50070 端口没有监听?

- 问下二次排序的使用场景有哪些?

- wordcount 执行不了,查日志提示 maximum-am-resource-percent is insufficient,应该怎么设置?

- 有 sparkSQL 了为啥还要 hive on spark 呢?

- 怎么对 hbase 中的数据进行清洗?

- spark 处理非结构化数据是怎么处理的?这个非结构化数据是怎么个数据能列举一下吗?

- map/reduce master 里的地址是用 mapred-site.xml 里的还是 yarn-site.xml 里的?

- map/reduce master 里的地址是用 mapred-site.xml 里的还是 yarn-site.xml 里的?

- map/reduce master 里的地址是用 mapred-site.xml 里的还是 yarn-site.xml 里的?

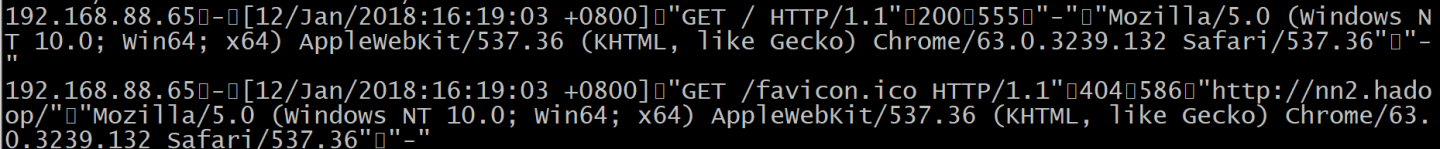

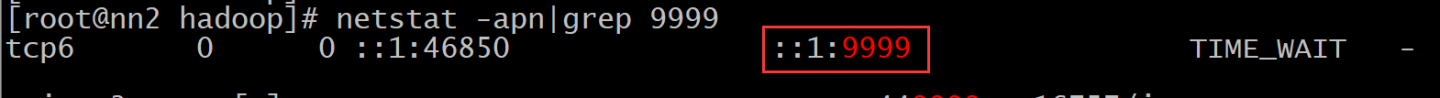

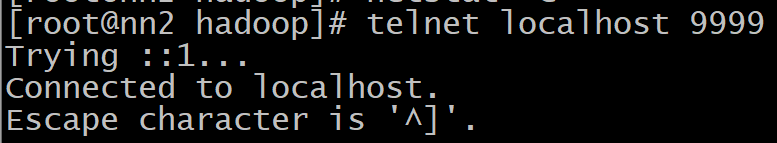

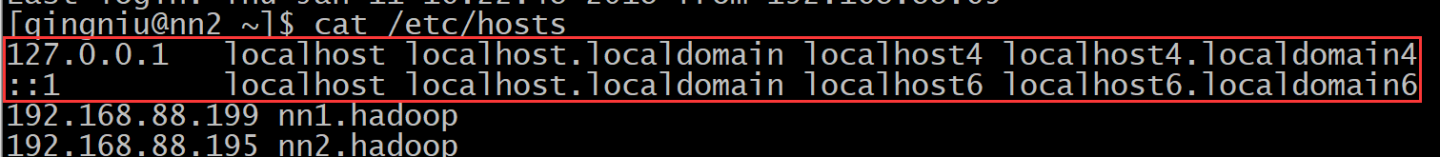

- 用 Linux 中 netcat 命令,客户端和服务端之间无法连接?