@tonly 你这个问题挺有意思的,所以我也愿意和你讨论。你那个看不全网页IDEA中会报jetty的错误,主要是找不到文件什么的。这个有可能是你IDEA在windows上的权限不够。所以和你这个本地的问题没有关系。主要的问题就是你的虚拟机能不能通过nat网络访问你的宿主机的ip和指定的端口。你配置的那个.1应该是NAT网络的网关吧,不知道这样配置可不可以,一般都是主机访问虚拟网络里面的机器。虚拟网络里面的机器访问不了主机的。

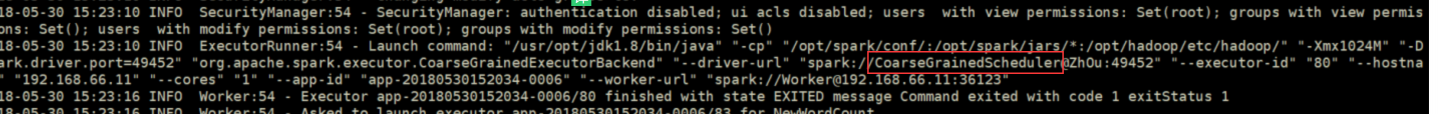

- 本地 Java 程序提交任务到 spark 集群无法执行,也没有报错,这是为什么?

- 请问如何去理解 MPP 架构呢?

-

信息被删除或无权限查看

- 本地 Java 程序提交任务到 spark 集群无法执行,也没有报错,这是为什么?

- 实时性高又涉及到复杂查询的用什么数据库?

- 本地 Java 程序提交任务到 spark 集群无法执行,也没有报错,这是为什么?

- 本地 Java 程序提交任务到 spark 集群无法执行,也没有报错,这是为什么?

- 本地 Java 程序提交任务到 spark 集群无法执行,也没有报错,这是为什么?

- 本地 Java 程序提交任务到 spark 集群无法执行,也没有报错,这是为什么?

- 本地 Java 程序提交任务到 spark 集群无法执行,也没有报错,这是为什么?

- 在电商项目中如何运用大数据技术?

- 在电商项目中如何运用大数据技术?

- 本地 Java 程序提交任务到 spark 集群无法执行,也没有报错,这是为什么?

- 有 R 开发 storm 和 spark 的案例或者资料吗?

- HBase 数据为何在一台机器上?